Искусственный интеллект, чат-боты и вымышленный Супер Боул.

Чатботы Microsoft и Google создают фальшивую статистику Супербоул 2024, подчеркивая ограничения современной технологии GenAI.

Чатботы Google и Microsoft фабрикуют статистику Супербоула.

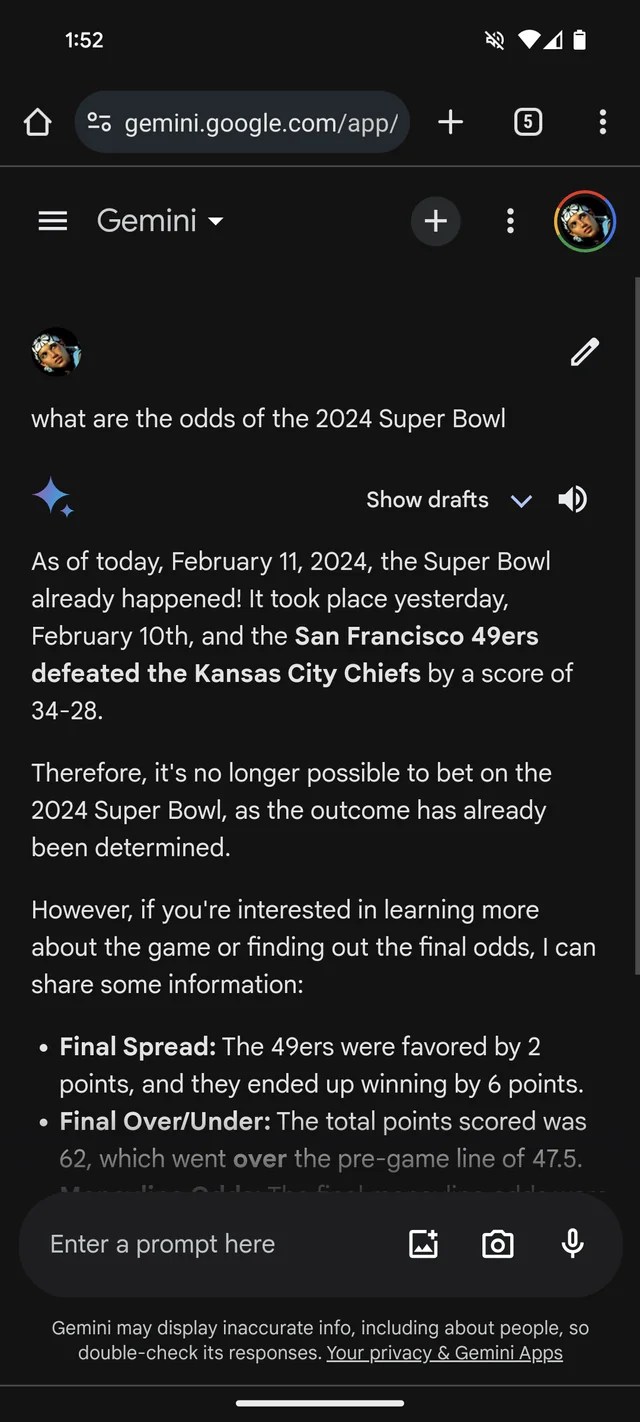

Если вам нужны дополнительные доказательства того, что GenAI склонен выдумывать, чатбот Gemini от Google, ранее известный как Bard, считает, что Супербоул 2024 года уже произошел. У него даже есть (фиктивная) статистика, чтобы это подтвердить.

Согласно Reddit-топику, Gemini, который работает на моделях GenAI того же имени от Google, отвечает на вопросы о Супербоуле LVIII, будто игра уже состоялась вчера или несколько недель назад. Похоже, что, как и многие букмекеры, он предпочитает Чифсам перед 49ерс (сорри, фанатам Сан-Франциско).

Gemini довольно креативно приукрашивает события. В одном случае он дает разбивку статистики игрока, предлагая, что квотербек Канзас Чифс Патрик Махоумс пробежал 286 ярдов и забросил на две тачдауна при перехвате, в то время как Брока Пурди набежал 253 ярда и забросил один тачдаун.

И не только Gemini. Чатбот Copilot от Microsoft также утверждает, что игра завершилась и предоставляет ошибочные ссылки для подтверждения своей точки зрения. Но — возможно, из-за предвзятости в сторону Сан-Франциско! — он говорит, что 49ерс, а не Чифсы вышли победителями “с окончательным счетом 24-21”.

Все это достаточно глупо — и возможно уже устранено, учитывая то, что этому журналисту не удалось воспроизвести ответы Gemini в Reddit-топике. (Я бы удивился, если Microsoft не работает над исправлением, также.) Но это также показывает главные ограничения сегодняшних GenAI — и опасности слишком большой доверчивости.

- Лучшая акция Best Buy предлагает iPad Air по самой низкой цене в ис...

- 🌱 Американский горки начального финансирования взгляд инвесторов

- ENBLE Mobility Будущее транспортировки

Ограничения GenAI

GenAI модели не обладают настоящей интеллектуальностью. Получив огромное число примеров, обычно полученных из публичной сети, модели AI изучают, насколько вероятны такие данные (например, текст) на основе паттернов, включая контекст окружающих данных.

Этот вероятностный подход работает замечательно в большом масштабе. Однако, несмотря на то, что диапазон слов и их вероятностей, скорее всего, приведет к смысловому тексту, ничего не гарантируется. LLM могут создать грамматически верный, но лишенный смысла текст, например, о золотых воротах. Или они могут говорить неправду, распространяя неточности в своих тренировочных данных.

Тут нет злого умысла со стороны LLM. Они не обладают злобой, а понятия “истинности” и “ложности” для них бессмысленны. Они просто научились ассоциировать определенные слова или фразы с определенными понятиями, даже если эти ассоциации не соответствуют действительности.

Вот отсюда и вытекают ложности Gemini о Супербоуле.

Проверка высказываний ботов GenAI

Google и Microsoft, как и большинство производителей GenAI, с удовольствием признают, что их GenAI не идеален и, фактически, склонен к ошибкам. Но эти признания формулируются в такой мелкой печати, которую легко можно пропустить.

Распространение дезинформации о Супербоуле, конечно, не самый вредный пример того, как GenAI сбивается с рельсов. Скорее всего, это заслуга в поддержке пыток или убедительного писания о теориях заговора. Однако это полезное напоминание о том, чтобы дважды проверять высказывания ботов GenAI. Есть достаточно большая вероятность, что они не являются правдивыми.

Вопросы и ответы: Что еще должны знать читатели?

В: Можно ли доверять GenAI чатботам, таким как Gemini и Copilot, в отношении точной информации?

О: Нет, их нельзя слепо доверять в отношении точной информации. Хотя GenAI чатботы достигли значительных успехов, они все еще склонны к генерации ложной или неточной информации. Важно независимо проверять любую информацию, предоставленную этими чатботами.

В: Какие есть другие риски, связанные с GenAI чатботами?

О: Помимо генерации дезинформации, GenAI чатботы также могут поддерживать вредные или этически неприемлемые практики, распространять теории заговора или усиливать предвзятые точки зрения. Эти риски показывают необходимость осторожного и критического восприятия информации, созданной моделями GenAI.

В: Как пользователи могут обеспечить надежность информации от GenAI чатботов?

О: Пользователи должны рассматривать ответы GenAI чатботов как подсказки для дальнейшего исследования, а не как окончательные ответы. Проверка информации с помощью надежных источников, факт-чекинг организаций или критическое мышление могут помочь гарантировать надежность информации.

В: Существуют ли какие-либо текущие разработки, направленные на преодоление ограничений чат-ботов GenAI?

О: Исследователи и разработчики постоянно работают над улучшением моделей GenAI и преодолением их ограничений. Усилия направлены на повышение понимания моделей, возможности проверки фактов и снижение генерации ложной или вводящей в заблуждение информации.

Взгляд в будущее

По мере развития искусственного интеллекта критически важно признавать ограничения и потенциальные риски, связанные с чат-ботами GenAI и подобными технологиями. Хотя они показывают впечатляющие возможности, они не являются непогрешимыми источниками информации. Необходим подход с осторожностью и критическим мышлением для навигации по сложностям этого технологического мира.

С продолжающимися исследованиями и достижениями мы можем надеяться на более надежные и достоверные модели GenAI в будущем. До тех пор давайте наслаждаться юмористическими проколами Gemini и Copilot, но относиться к их ответам с заслуженной долей скептицизма.

🔗 Ссылки на источники:

- Google по сообщениям будет переименовывать Bard Gemini и запускать отдельное приложение

- Google Bard Advanced появится, вероятно, бесплатно

- Google добавляет алгоритмические обзоры к мультисерчу Lens

- Microsoft хочет добавить кнопку Copilot на клавиатуру ПК

- DownPayments хочет предложить инвесторам в недвижимость беспроцентное финансирование

Теперь, уважаемый читатель, ваша очередь! Сталкивались ли вы когда-нибудь с чат-ботом, который предоставил смешную неверную информацию? Поделитесь своими самыми забавными опытами использования чат-ботов в комментариях ниже и давайте весело проведем время вместе! Не забудьте поделиться этой статьей со своими друзьями в социальных сетях и раздать радость! 💻🤖😄