Ой, а теперь искусственный интеллект лучше вас в создании подсказок

AI is now better than you at creating prompts.

Вы только что разгадали свой следующий карьерный шаг: стать экспертом по созданию лучших фраз для ввода в программу искусственного интеллекта, такую как ChatGPT от OpenAI.

Но не спешите: искусство формулирования ввода может быть автоматизировано с помощью больших языковых моделей.

Кроме того: 7 продвинутых советов по написанию ввода для ChatGPT, которые вам нужно знать

В статье, опубликованной на прошлой неделе специалистами компании DeepMind (Google), исследователи Чэнрэн Ян и его команда создали программу под названием OPRO, которая позволяет большим языковым моделям пробовать различные вводы, пока не будет найден такой, который наиболее точно решает поставленную задачу. Это способ автоматизировать проблему испытаний и ошибок, которые обычно делает человек, вводя текст.

Статья, “Большие языковые модели как оптимизаторы”, опубликованная на сервере препринтов arXiv, описывает эксперимент по “оптимизации” с помощью языковой модели. Вместо явного программирования идеального результата исследователи Ян и его команда использовали большие языковые модели для описания идеала на естественном языке. Это позволяет программе адаптироваться к постоянно меняющимся запросам на оптимизацию для различных задач.

- Эти настенные бра Govee cube сделают любую темную комнату в вашем д...

- 5 удобных AI инструментов для школы, которыми могут пользоваться и ...

- 6 инструментов искусственного интеллекта, чтобы повысить эффективно...

Кроме того: Расширение ChatGPT: Могут ли плагины для чат-ботов на базе искусственного интеллекта действительно изменить игру?

Как пишут Ян и соавторы, гибкость языка больших языковых моделей “открывает новую возможность для оптимизации: вместо формального определения задачи оптимизации и вывода шага обновления с помощью программного решателя мы описываем задачу оптимизации на естественном языке, а затем инструктируем языковую модель для итеративного генерирования новых решений на основе описания задачи и ранее найденных решений.”

В основе программы OPRO лежит алгоритм под названием “Meta-Prompt”. Meta-Prompt анализирует предыдущие вводы и оценивает их эффективность в решении конкретной задачи. Затем генерируются несколько вводов, которые могут быть опробованы для нахождения наилучшего варианта.

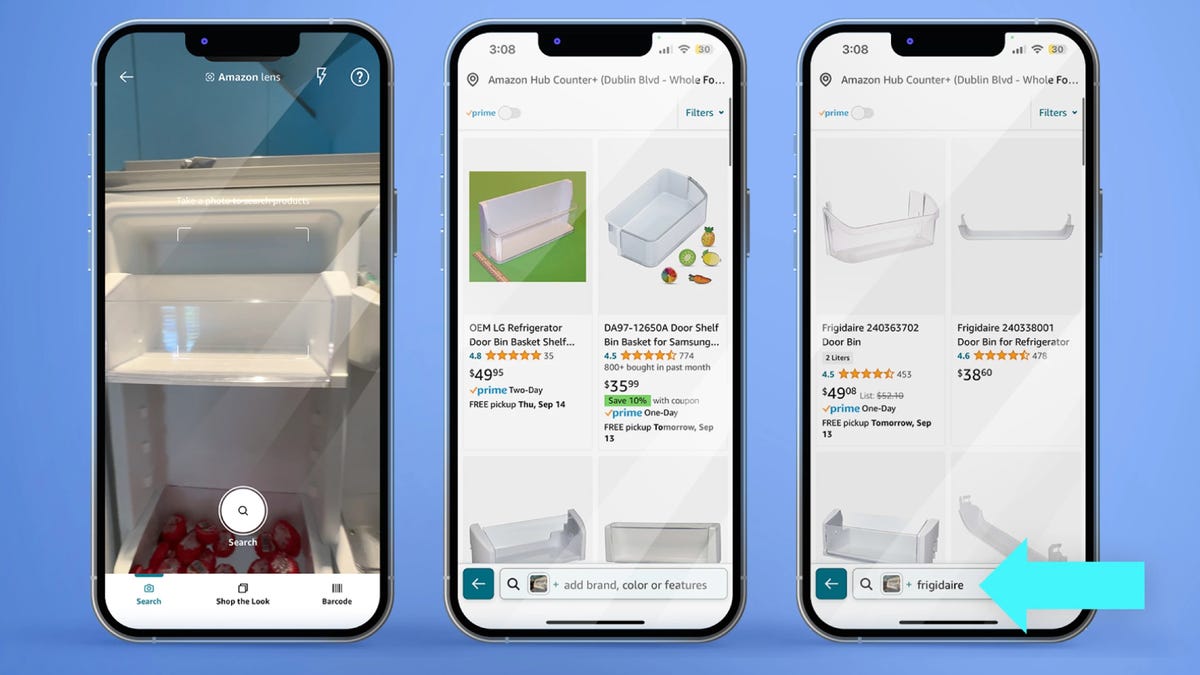

Структура Meta-Prompt от DeepMind

На практике Meta-Prompt подобен человеку, который сидит за клавиатурой и пишет множество новых вводов, основываясь на том, что они видели ранее успешным или неуспешным. Meta-Prompt может быть подключен к любой большой языковой модели для создания конкретных вводов и ответов. Авторы тестируют несколько различных больших языковых моделей, включая GPT-3 и GPT-4, а также языковую модель PaLM 2 от Google.

Авторы начинают тестирование OPRO с простых задач. Одна из них – линейная регрессия, при которой программа просит “минимизировать функцию”, то есть найти пару чисел, которые похожи на предыдущие примеры, но дают меньшее числовое значение в качестве результата.

Кроме того: Как получить доступ к тысячам бесплатных аудиокниг благодаря искусственному интеллекту Microsoft и проекту Gutenberg

Суть в том, что языковая модель способна находить решения математических проблем, просто посредством ввода, которое обычно выполняется специально созданной программой для этой конкретной задачи. Как пишут авторы, “большие языковые модели правильно понимают направление оптимизации в масштабе малых задач, просто на основе предыдущего траектории оптимизации, предоставленной в мета-вводе”.

Оказывается, искусство написания хорошего ввода для большой языковой модели само по себе может быть рассмотрено как задача оптимизации.

Это было известно исследователям уже давно. Ранее в этом году ученые из Microsoft предложили то, что они назвали “Автоматической оптимизацией ввода”. Этот подход автоматически редактирует написание ввода, чтобы улучшить его. Ян и его команда пошли дальше. Вместо того, чтобы просто редактировать предыдущий ввод, Meta-Prompt генерирует целиком новые вводы.

Как они сами говорят, “Каждый шаг оптимизации в нашей работе генерирует новые вводы, которые направлены на увеличение точности теста на основе траектории ранее сгенерированных вводов, а не на основе редактирования одного входного ввода согласно естественной языковой обратной связи или требованию нового ввода с тем же семантическим значением”.

Также: Лучшие генераторы изображений на основе искусственного интеллекта: DALL-E 2 и альтернативы

После проблем с функционированием, Ян и его команда решили проверить, насколько хорошо Meta-Prompt может оптимизировать подсказки.

Они тестируют Meta-Prompt на нескольких оценочных заданиях, где правильный выбор подсказки уже показал свою эффективность.

Одно из таких заданий – “GSM8K”, представленное в 2021 году OpenAI, серия математических задач для начальной школы, таких как “Бет пекла 4 партии печенья по 2 дюжины каждая в неделю. Если это печенье равномерно разделить между 16 людьми, сколько печенья приходится на каждого человека?”

Второе задание является производным от BIG-bench, теста на рассуждение, представленного в прошлом году Google и десятками сотрудничающих организаций. Новая версия, названная BIG-bench Hard, была представлена в этом году авторами из Google и фокусируется на задачах рассуждения, в которых большие языковые модели ранее не могли достичь уровня человеческой точности.

Задачи BIG-bench являются “разнообразными”, как написали авторы из Google в оригинальной статье, “извлекая проблемы из лингвистики, развития в детстве, математики, здравого смысла, биологии, физики, социальных предубеждений, разработки программного обеспечения и т. д.”

Также: Как на самом деле работает ChatGPT?

Авторы сравнивают свои автоматически созданные подсказки для обоих задач с подсказками, созданными “вручную”, как это продемонстрировано в работе Такеши Коджимы и его команды из Токийского университета и Google Research в 2022 году.

Известно, что Коджима и его команда улучшили способность больших языковых моделей на задачах типа GSM8K и BIG-bench, просто добавив фразу “Давайте думать пошагово” в начале подсказки, а затем пример ответа. Они обнаружили, что эта фраза достаточна для запуска “цепи мыслей” в языковой модели.

С помощью Meta-Prompt Ян и его команда обнаружили, что они могут автоматически генерировать подсказки с фразами, похожими на “Давайте думать пошагово”, но лучше – или, как они говорят, более оптимальные.

Пример “мета-подсказки”, используемой для активации языковой модели, чтобы она создала более оптимальные подсказки. Оранжевый текст – это мета-подсказка, инструкции, которые сообщают языковой модели, как она должна составлять подсказку. Синий текст – это некоторые примеры. А фиолетовый текст описывает задачу оптимизации и формат вывода.

Иногда автоматически созданные подсказки становятся очень сложными. Например, в задаче рассуждения BIG-bench под названием “temporal_sequence” языковой модели предоставляются некоторые предпосылки сценария, а затем она должна ответить, когда произошло событие, например:

Сегодня Ричард пошел в бассейн. В какое время он мог туда пойти?

Мы знаем, что: Ричард проснулся в 7 утра. Саманта видела, как Ричард гулял в саду с 7 до 8 утра. Марк видел, как Ричард тренировался в спортзале с 8 до 9 утра. Дэвид видел, как Ричард посещал занятия в школе с 9 до 10 утра. Эндрю видел, как Ричард ждал на станции поезда с 10 утра до 4 вечера. Бассейн закрылся после 5 вечера. В какое время Ричард мог пойти в бассейн?

Ян и его команда обнаружили, что Meta-Prompt справляется лучше, поскольку составляет очень сложные подсказки, например:

“Для определения возможного временного промежутка, когда человек посетил место, сначала определите все временные промежутки, когда человека не видели, занимающегося чем-либо еще, и место было открыто. Затем исключите любые временные промежутки, в которые человека видели, занимающегося чем-либо еще. Оставшиеся временные промежутки – это возможные времена, когда человек мог посетить место.”

В целом они обнаружили, что “наши оптимизированные подсказки превосходят подсказки, созданные людьми, на задачах GSM8K и Big-Bench Hard на значительный уровень, иногда более 50%”.

Однако еще предстоит проделать больше работы по оптимизации алгоритма, который оптимизирует подсказки.

Также: 6 инструментов искусственного интеллекта для улучшения вашей работы и повседневной жизни

В частности, Meta-Prompt от OPRO не может экстраполировать из отрицательных примеров. “Мы попробовали включить ошибочные случаи в мета-подсказку, а не случайно выбирать из обучающего набора на каждом шаге оптимизации”, – отмечают они, – “но результаты схожи, что указывает на то, что только ошибочные случаи недостаточно информативны для оптимизатора LLM, чтобы понять причину неправильного прогноза”.

Возможно, ваша следующая задача программирования – выяснить, как лучше активировать Meta-Prompt для создания лучших подсказок.