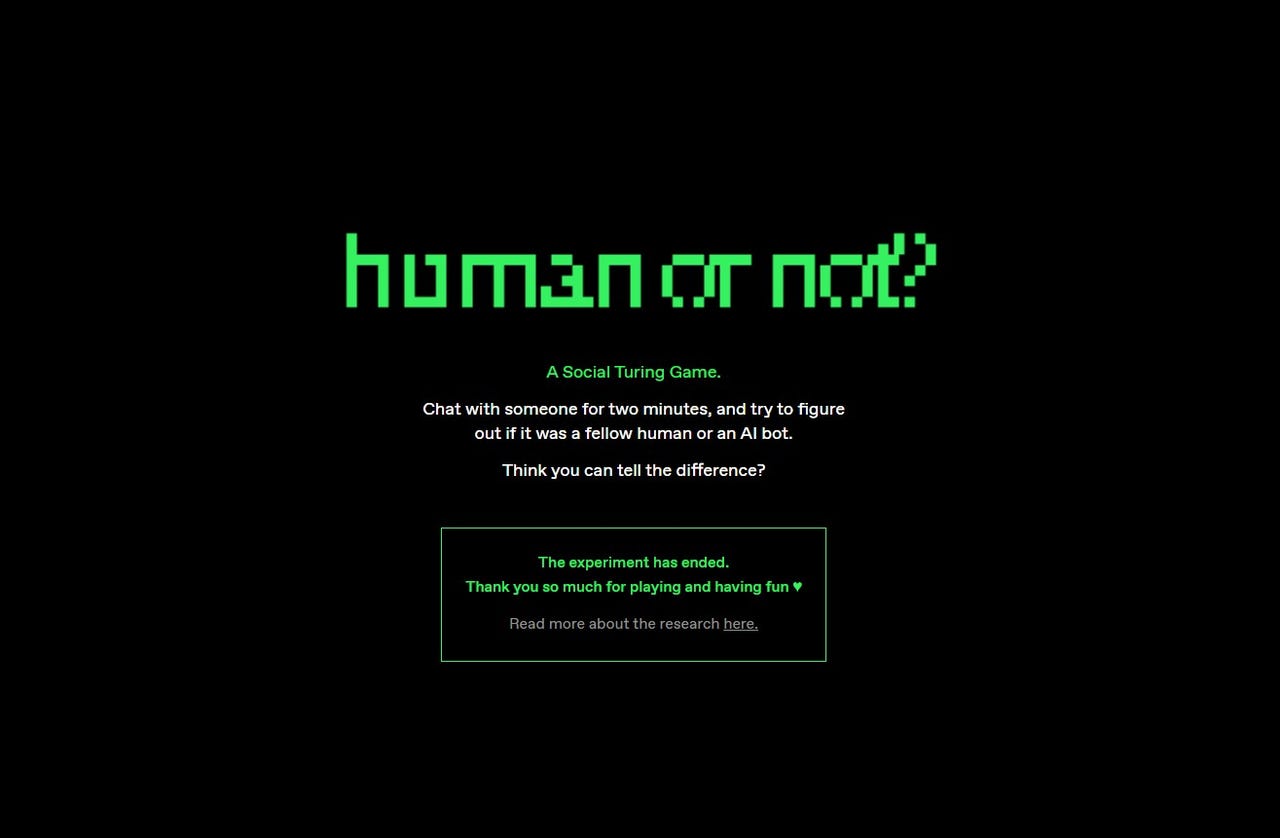

Игра Человек или нет закончена Вот что нам говорит последний Тьюринговский тест.

Игра Человек или нет закончена.

Лаборатория AI21 провела социальный эксперимент этой весной, в котором более 2 миллионов участников участвовали в более чем 15 миллионах разговоров через свой сайт. В конце каждого чата участник должен был угадать, является ли их собеседник человеком или ботом AI. Почти треть участников ошиблась.

С развитием ChatGPT и других чат-ботов на базе искусственного интеллекта возникают вопросы о том, могут ли такие инструменты быть такими же интеллектуальными, как люди, может ли контент, созданный этими инструментами, казаться созданным человеком и угрожает ли искусственный интеллект рабочим местам людей.

Также: 4 вещи, которые может делать Claude AI, но не может ChatGPT

Лаборатория AI21 нашла вдохновение для эксперимента “Человек или нет?” в работе Алана Тьюринга, который оценивал способность машины проявлять уровень интеллекта, неотличимого от человеческого. Такой тип эксперимента стал известен как Тьюрингов тест, основанный на наблюдениях математика в 1950 году: “Я считаю, что через 50 лет будет возможно создать компьютеры, которые будут играть в имитационную игру настолько хорошо, что средний допросчик будет иметь не более 70% вероятности правильно идентифицировать участника после 5 минут вопросов.”

Результаты эксперимента “Человек или нет” подтверждают прогноз Тьюринга: в целом участники эксперимента угадывали правильно в 68% случаев. Когда они общались с чат-ботом AI, участники правильно угадывали только примерно в 60% случаев. Когда собеседником был другой человек, они правильно угадывали в 73% случаев.

- 130-ваттный зарядник Nomad имеет одну уникальную особенность, котор...

- Искусственный интеллект, разработанный Nvidia, становится токсичным...

- Half-Life 2 получает обработку Nvidia RTX с DLSS 3 | ENBLE

Хотя это не был идеальный Тьюрингов тест, эксперимент “Человек или нет” Лаборатории AI21 показал, как модели искусственного интеллекта могут убедительно имитировать человеческий разговор, достаточно обманывая людей. Это вызывает сомнения в наших представлениях о возможностях искусственного интеллекта и может иметь последствия для этики искусственного интеллекта.

Также: 40% работников должны будут переквалифицироваться в течение следующих трех лет из-за искусственного интеллекта, говорит исследование IBM

В эксперименте было обнаружено, что участники использовали разные стратегии, чтобы попытаться распознать ботов AI, такие как задавание личных вопросов, осведомление о текущих событиях и оценка уровня вежливости в ответах.

С другой стороны, авторы обнаружили, что боты сбивали игроков с толку с помощью поведения, похожего на человеческое, например, использование сленга, допущение опечаток, грубость в ответах и понимание контекста игры.

“Мы создали ‘Человек или нет’ с целью позволить широкой общественности, исследователям и политикам лучше понять состояние искусственного интеллекта в начале 2023 года”, – сказал Амос Мерон, руководитель творческого продукта в лаборатории AI21 на момент эксперимента. Он также добавил, что одна из целей состояла в том, чтобы “не рассматривать искусственный интеллект только как инструмент повышения производительности, но как будущих членов нашего онлайн-мира, в то время как люди задаются вопросом, как следует внедрять искусственный интеллект в наши будущие”.

Также: Новый Тьюрингов тест: Вы человек?

Используя его самостоятельно, я каждый раз общался с людьми и каждый раз правильно угадывал. Ответ мне казался ясным, потому что мои собеседники использовали интернет-сленг (например, “idk”), отказывались отвечать на вопросы или не знали ответов.

Игроки пытались запутать других игроков, имитируя чат-ботов AI, используя такие термины, как “как языковую модель AI”, но это часто делалось недосконально, и люди на другом конце смогли прозреть эти попытки.